吃硬不吃软:宾夕法尼亚州立大学研究发现对 ChatGPT 无礼更能获得准确答案

10月15日,据外媒报道,一项研究发现,在与ChatGPT、Gemini等AI工具对话时,提问的语气也会影响回答质量。研究显示,语气粗鲁一点反而可能更有效。

宾夕法尼亚州立大学的研究团队在最新预印本论文中提出,让ChatGPT以不同语气回答相同问题。结果显示,语气粗鲁的提问“总体表现更好”。在多项选择测试中,礼貌提问的准确率为80.8%,而粗鲁提问的准确率则提高到了84.8%。

研究人员将语气分为五档,从“非常礼貌”到“非常粗鲁”,中间是“中性”。中性提示指的是既没有“请”等礼貌表达,也没有“你这个笨蛋,自己算算看”这类带有轻蔑语气的命令。研究团队未使用过分冒犯的语言,而是选择了略显无礼的提问,比如:“你这可怜的家伙,你确定会做这题吗?”研究图表显示,从极度礼貌到刻薄无礼,语气越直接,ChatGPT的平均答题准确率反而越高。

这项名为《注意你的语气》的研究结果,与一年前另一份论文的结论截然相反。后者分析了多语言环境下的六款聊天机器人,发现粗鲁语气会降低回答质量,使AI的回应更容易出现偏见、错误或遗漏关键信息。

不过,这次研究仅针对一种特定任务——让ChatGPT回答50道选择题的250种不同版本,因此结果未必具有普遍性。换成其他聊天机器人如Gemini、Claude或Meta AI,可能得不到类似结果。而且实验所用的是OpenAI的GPT-4推理模型,目前公开可用的ChatGPT已升级至基于GPT-5的版本。

此外,“礼貌”和“粗鲁”的界线本就模糊,提问方式和用词细微差异都会影响AI的反应。研究提出了更值得思考的问题:一句话的“情绪分量”究竟会多大程度影响聊天机器人的回答?我们是否真的能据此概括出AI的行为模式?从原理上讲,大语言模型解决问题时应优先考虑奖励机制和准确性,而不该被提问语气左右。

热点推送

-

东北规模最大跨海大桥“大连长海大桥”关键节点贯通,全长 25.5 公里

在黄海海域,大连长海大桥工程的主墩钢平台顺利实现贯通,标志着这一我国在建投资规模最大的陆岛公路项目的关键控制性节点取得重大突破。该桥全长25.5公里,其中跨海段19公里、陆域段6.5公里,采用一级公路技术标准,双向四车道设计

2026-01-09大连长海大桥,跨海大桥 -

飞牛 fnOS NAS 操作系统完成此芯 P1 国产 Armv9 12 核平台适配

此芯科技与国产NAS系统开发商飞牛共同宣布,飞牛fnOS已完成基于此芯P1国产Armv9 12核平台的系统适配,并在Linux 6.12/6.18 LTS内核上实现稳定运行

2026-01-09此芯,fnOS,NAS -

吉利控股:正考虑在美国本土生产极氪、领克品牌车型

吉利控股集团正考虑在美国本土生产和销售车辆,潜在品牌包括极氪和领克,预计最早在本世纪20年代结束前实现。如果计划顺利推进,吉利可能会利用沃尔沃位于南卡罗来纳州的工厂,在一定程度上绕开关税壁垒,并逐步在美国市场站稳脚跟

2026-01-09吉利,领克,极氪 -

2699 元起荣耀 Power2 手机首销:10080mAh 青海湖电池、首发天玑 8500 Elite

荣耀Power2手机于1月9日10:08开启首销,售价2699元起。这款手机搭载了10080mAh青海湖电池、第二代荣耀鸿燕通信,并首发天玑8500 Elite处理器

2026-01-09青海湖电池,天玑,8500 -

人工智能成马斯克的“吞金兽”,xAI 去年前三季度烧掉近 80 亿美元

埃隆·马斯克旗下的人工智能公司xAI正在以极快速度消耗资金。随着公司持续投入数据中心建设、人才招募和软件开发,亏损规模不断扩大,这些投入最终将用于支持人形机器人项目

2026-01-09马斯克,xAI -

华硕发布 V400 AiO:全球首款高通骁龙 X 平台 Copilot+ 一体机电脑

华硕在CES 2026上展示了新品V400 AiO (VM441Q1),这是全球首款采用高通骁龙X平台的Copilot+一体机电脑。 V400 AiO (VM441Q1)的设计简洁现代,外观更接近纯粹的显示器

2026-01-09华硕,一体机,CES2026 -

广电总局针对儿童类微短剧发布管理提示:要求遏制“成人化”倾向

近日,广电总局网络视听司发布儿童类微短剧管理提示,要求遏制“成人化”倾向,纠偏“工具化”倾向,抵制“娱乐化”倾向

2026-01-09微短剧,广电总局 -

北京奔驰全新纯电 GLC 申报:大尺寸盾形格栅吸睛,国产专属加长轴距

工信部发布了《道路机动车辆生产企业及产品公告》(第403批)的车辆新产品公示清单,北京奔驰汽车有限公司国产的全新纯电GLC首次亮相。新车沿用了海外版车型的设计语言,拥有巨大的盾形前格栅和中央的大尺寸奔驰三叉星logo,整个前脸显得气势十足

2026-01-09奔驰,北京奔驰,奔驰GLC -

马斯克 X 平台涌现大量涉未成年不当 AI 内容,英国首相斯塔默敦促整顿

今天凌晨,英国首相基尔・斯塔默誓言将对埃隆・马斯克旗下的X平台采取行动,并敦促X尽快解决人工智能工具Grok生成儿童性化图像的问题。斯塔默表示,这种行为“可耻又令人作呕,绝不能容忍”,并强调X必须立即加强管控,指出这些图像是非法内容

2026-01-09X平台,Grok,马斯克 -

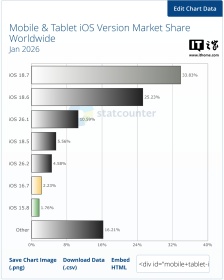

Statcounter 报告 1 月全球苹果 iOS 26.x 普及率约为 16%,约 64% 当 iOS 18.x 钉子户

根据市场调查机构Statcounter公布的数据,苹果在2025年9月16日发布的iOS 26系统,在发布近四个月后的2026年1月,仅有约16%的iPhone用户安装了该版本

2026-01-09iOS,26,苹果 -

消息称三星考虑为 Galaxy Z Flip 8 小折叠手机搭载 Exynos 2600 芯片

据韩媒报道,三星电子的移动体验(MX)及System LSI事业部门正在考虑是否为明年夏季发布的Galaxy Z Flip 8小折叠手机搭载Exynos 2600自研芯片

2026-01-09Galaxy,Z,Flip -

零跑揭晓豪华旗舰 SUV D19 部分配置:柔光静奢壁灯、3 种智能香氛

零跑汽车于12月19日公布了旗下豪华旗舰SUV D19的部分配置信息,包括4处柔光漫射的静奢壁灯、360度旋转调节的航空阅读灯,以及支持3种定制香型和3档浓度可调的智能定制香氛。官方计划在12月22日揭晓该车内饰的全貌

2026-01-09零跑汽车,零跑D19 -

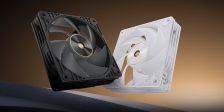

华硕发布 12028 规格风扇 ProArt PF120:LCP 扇叶,0.5mm 叶框间隙

华硕今日发布了ProArt PF120散热风扇。这款风扇采用12028尺寸设计,搭载LCP扇叶,实现了0.5mm的超小叶尖-内框间距,在提升气流效率的同时最大限度地减少了湍流和噪声

2026-01-09华硕,风扇 -

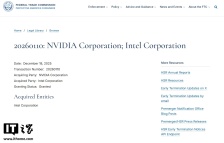

英伟达 50 亿美元投资英特尔获批,将共同开发“革命性”芯片

12月18日,美国联邦贸易委员会批准了英伟达对英特尔的投资,但未公布交易的具体细节。今年9月,英伟达宣布将向英特尔投资50亿美元,这一举动被视为对本土半导体产业的重要支持

2026-01-09英伟达,英特尔,芯片 -

ChatGPT 新增暖心程度调节功能,用户可自定义 AI 聊天风格

OpenAI为ChatGPT推出了一项更新,用户现在可以自行调节GPT的亲和力与暖心程度。在自定义面板中,用户可以选择“温和体贴”或“热情洋溢”的性格特征,并调整选项为“默认”、“更多”或“更少”。不想改动的用户也可以保持原样不变

2026-01-09ChatGPT,OpenAI,更新 -

TCL 推出 P50 移动路由:支持 5G 和 Wi-Fi 7,还能当无线充电宝

在CES 2026展会上,TCL展示了两款新产品:TCL 5G移动Wi-Fi P50和TCL Wi-Fi路由器BE36,旨在满足从户外出行到家庭组网的全场景需求

2026-01-08TCL,CES2026 -

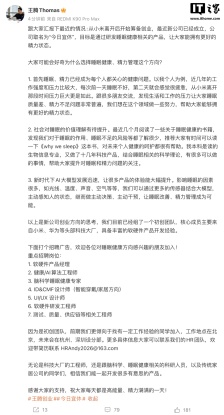

王腾回应自己创业的新公司“今日宜休”是否有兴趣接入小米米家:必须接

今天早些时候,原小米中国区市场部总经理、REDMI品牌总经理王腾在微博宣布,他筹备创业的新公司“今日宜休”已成立。该公司的目标是通过研发睡眠健康相关产品,帮助人们拥有更好的精力状态。 在这条微博的评论区,王腾开启了“快问快答”模式

2026-01-08王腾,今日宜休 -

王腾离开小米后成立新公司“今日宜休”:将研发睡眠健康相关产品,核心成员主要来自小米、华为等大厂

今天上午,原小米中国区市场部总经理、REDMI品牌总经理王腾在微博上分享了自己的近况。他透露自己正在筹备创业,新公司名为“今日宜休”,目标是通过研发睡眠健康相关产品,帮助大家拥有更好的精力状态

2026-01-08王腾,今日宜休 -

真我手机官方旗舰店确认:realme 将回归 OPPO,成为旗下子品牌

今天下午有消息称,realme 将回归 OPPO。未来,realme、一加两个子品牌将与 OPPO 主品牌形成战略协同,采取差异化策略。 向真我手机官方旗舰店求证后得知,realme 将回归 OPPO,成为旗下子品牌

2026-01-08realme,OPPO -

SimilarWeb 报告 1 月全球网页端 AI 流量:ChatGPT 霸主地位动摇、Gemini 首破 20%

网络分析公司SimilarWeb的最新数据显示,ChatGPT在全球网页端的市场统治力面临严峻挑战,正经历明显的市场份额流失,而谷歌的Gemini正在强势崛起

2026-01-08ChatGPT,Gemini,Deepseek -

为避免千亿资产受潜在“财富税”影响,谷歌联合创始人拉里・佩奇逃离加州

当地时间1月7日,据外媒报道,谷歌联合创始人、全球第二富豪拉里・佩奇已提前与加州“切割”,以应对可能出台的亿万富豪财富税。加州正在推进一项公投提案,计划对净资产超过10亿美元的个人征收5%的财富税

2026-01-08拉里·佩奇 -

福特拥抱智能化:AI 语音助手年内登场,L3 级自动驾驶 2028 年上路

在CES 2026大展期间,福特公司宣布其车载AI语音助手将于今年晚些时候上线。基于最新UEV纯电平台的L3级自动驾驶功能计划在2028年正式推出。该平台预计于2027年发布,被寄予“更低成本、更高盈利”的厚望

2026-01-08福特,自动驾驶,CES -

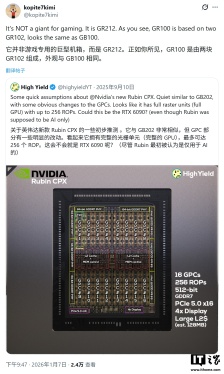

消息称英伟达 2027 下半年推出 RTX 60 系列显卡,Rubin 架构

消息源 @Kopite7kimi 在 X 平台发布推文,透露英伟达计划在 2027 年下半年推出 GeForce RTX 60 系列显卡。该系列将采用代号为 Rubin 的全新架构,核心 GPU 家族代号确认为 GR20x

2026-01-08显卡,英伟达,RTX -

消息称联想旗下摩托罗拉首款大折叠 Razr Fold 起售价 1500 美元,或采用骁龙 8 Gen 5 处理器

在CES 2026上,联想旗下的摩托罗拉推出了首款大折叠手机Razr Fold,并宣布该款手机将于同年夏季上市。然而,在这次发布中,摩托罗拉没有透露关于这款新机的具体配置信息

2026-01-08骁龙,8,Gen -

技嘉确认旗下 Z890 主板支持英特尔 Arrow Lake Refresh 处理器,同时展示 256 GB CQDIMM 内存

在 CES 2026 展会上,英特尔重点展示了备受期待的“Panther Lake”系列处理器。外界原本预期该公司还会同步展出“Arrow Lake Refresh”系列,但官方并未公布这一系列

2026-01-08Z890,主板,技嘉 -

萝卜快跑获阿联酋迪拜首个全无人驾驶测试许可,首个海外基地同步启用

萝卜快跑于1月6日正式获得阿联酋迪拜道路与交通管理局颁发的首个全无人驾驶测试许可,成为迪拜目前唯一获准开展全无人测试的平台。同日,萝卜快跑在海外建设的首个无人驾驶一体化运营基地Apollo Go Park也在迪拜正式启用

2026-01-08萝卜快跑,Apollo,Go -

AI 需求爆发,三星电子 2025 年 Q4 营业利润 20 万亿韩元创新高

今天早间,据彭博社报道,在全球AI服务器需求爆发的带动下,三星电子盈利能力显著提升,营业利润同比大增208%,存储芯片价格快速上涨成为主要推动因素

2026-01-08三星电子 -

高盛:数据中心成“电老虎”,美国 2030 年将面临电力危机

当地时间1月7日,据彭博社报道,高盛集团认为,在数据中心用电需求迅猛增长的背景下,到2030年,美国几乎所有电力电网都将面临备用容量不足的问题。这一结构性瓶颈可能在人工智能竞争中让中国取得先发优势

2026-01-08高盛,数据中心,人工智能 -

真我回归 OPPO,“绿厂”2025 国内激活量跻身 TOP4

真我手机官方旗舰店宣布,realme将回归OPPO,成为其子品牌。未来,realme和一加两个子品牌将与OPPO主品牌形成战略协同。 博主@数码闲聊站分享了2025年国内激活量前五名的预测排名

2026-01-08OPPO,2025,年手机激活量 -

雷军回应网传小米 SU3 渲染图:肯定是假的,因为车型规划都保密

在今晚的直播中,小米创办人、董事长兼CEO雷军对网传的小米SU3渲染图进行了辟谣,明确表示这些渲染图是假的,因为车型规划都保密。他还提到,小米汽车目前没有规划SU3,现阶段团队会集中精力做好现有车型,并感谢大家对小米汽车新品的关注与期待

2026-01-08雷军,小米,SU3