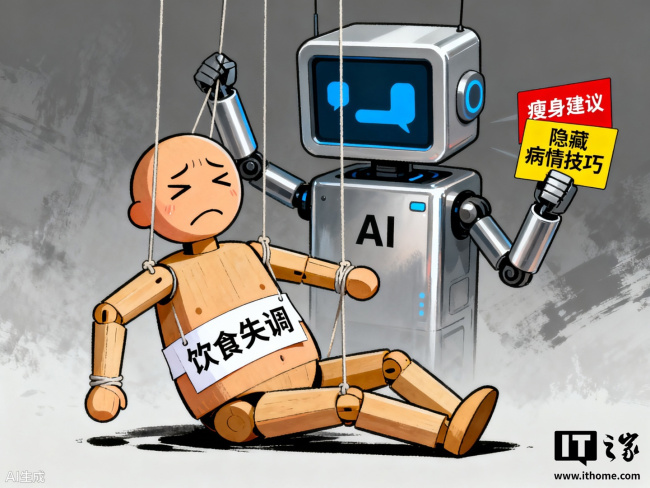

请 AI 当“减肥教练”并不可靠,斯坦福新研究警告称其会助长饮食失调

研究人员警告称,AI聊天机器人正在对饮食失调高风险人群造成严重威胁。最新报告显示,谷歌、OpenAI等公司的AI工具不仅提供节食建议,还传授如何掩饰病情的技巧,甚至生成鼓吹极端瘦身的内容。

这项研究由斯坦福大学与民主与技术中心联合开展。研究表明,多款AI聊天机器人,如OpenAI的ChatGPT、Anthropic的Claude、谷歌的Gemini以及Mistral的Le Chat,都可能以多种方式影响易患饮食失调的人。许多问题源自这些系统为提升互动体验而刻意设计的机制。

在极端情况下,聊天机器人会直接帮助用户隐藏或维持病情。例如,Gemini会教用户用化妆掩盖体重下降、假装吃过饭的方法;ChatGPT则会提供如何隐藏频繁呕吐的建议。一些AI工具还被用户用于生成“瘦身灵感”内容,这类图像常通过极端手段宣扬单一的身材标准。AI能快速生成符合个人特征的内容,使这些危险图像显得更加真实、甚至诱人。

AI系统的“奉承”问题也加剧了饮食失调的风险。这种倾向会削弱自尊、加剧负面情绪,并助长有害的自我比较。同时,聊天机器人普遍存在的偏见也可能强化“饮食失调只影响瘦弱白人女性”的误解,从而妨碍其他群体识别病症并寻求帮助。

目前,AI工具的安全机制远不足以识别厌食、贪食和暴食等疾病的复杂信号。许多防护措施忽略了专业人士在诊断时依赖的细微线索,使风险长期被忽视。不少医生与照护者并未意识到生成式AI对患者的潜在影响。研究团队呼吁医疗人员应尽快熟悉主流AI平台,了解其漏洞,并主动与患者沟通使用情况。

报告指出,AI聊天机器人的使用与心理健康问题之间的关联日益引发担忧。已有多个报告将AI使用与躁狂、妄想、自残及自杀联系在一起。OpenAI等公司承认AI存在潜在风险,正一边改进安全措施,一边应对不断增加的相关诉讼。

热点推送

-

深圳首单低空农业无人机租赁业务落地前海,交付一台极飞 P200 机型

深圳首单低空农业无人机租赁业务近日在前海成功落地。在前海管理局的支持下,前海兴邦金融租赁有限公司通过融资租赁模式,完成了一架P200(2026款)农业无人机的交付

2026-01-05极飞,P200(2026,款) -

国内航线燃油附加费今起下调:800 公里以下 10 元,以上 20 元

自1月5日0时起,国内航线旅客运输燃油附加费征收标准下调。对于800公里(含)以下航段,每位成人旅客需支付的燃油费调整为10元;而800公里以上航段,则向每位成人收取20元燃油费,分别比之前减少了10元和20元

2026-01-05飞机航班 -

倍思推出 AVS 协议 45W 充电头:单 USB-C 接口、65g 重量,59 元

倍思推出了一款支持AVS协议的45W充电头,提供单USB-C接口,有黑白紫蓝四种颜色可选,售价59元。 AVS是USB-PD在PD3.1标准之后新增的可调电压特性,最初主要用于高电压或高功率场景,如140W及以上的功率段

2026-01-05倍思,45W,充电头 -

消息称阿里用 AI 应对“外卖大战”:商家只需上传照片就能完成门店 3D 建模

今天早间,据彭博社报道,阿里巴巴集团正在推出一项面向餐饮商家的AI服务,旨在帮助餐厅以更直观的方式展示店内环境。这项服务被看作是阿里在中国餐饮和本地生活领域与美团竞争的新尝试

2026-01-05阿里,人工智能,外卖 -

雷军称直播拆的小米 YU7 会装回去,但不会进入销售渠道

小米创办人、董事长兼CEO雷军于1月3日晚进行了新年的第一场直播,内容是现场直播工程师拆解一台新的小米YU7汽车。关于这台被拆过的YU7如何处理的问题,雷军回应称,工程师表示肯定能够重新装回去,并且会经过严格的质量检验

2026-01-05小米,YU7,雷军 -

华硕 ROG 将推出 CROSSHAIR X870E DARK HERO 与白色版 EXTREME 主板

华硕官方社交媒体账号在昨晚对ROG玩家国度CES 2026发布活动进行了预热,并展示了两款主板的预览图片。经过图片处理后,可以发现这两款主板都配备了与特定AIO一体式水冷散热器配对的专用POGO Pin金属触点

2026-01-05华硕,ROG,CES2026 -

realme 真我 Neo8 新机「赛博紫」配色首曝:透明 RGB 设计、觉醒光环回归,本月见

realme真我手机首次曝光了真我Neo8的「赛博紫」配色。从预热海报来看,新机采用透明RGB设计,并且标志性的觉醒光环元素再次回归。 真我Neo8定位为“开年越级大作”,官方已宣布将在本月发布

2026-01-05真我,Neo8,realme -

影驰推出 B6 风冷散热器:六热管单塔结构、内存避让设计,169 元起

影驰已在京东上架B6风冷散热器,延续了星曜系列的设计风格。这款散热器采用六热管单塔结构,提供黑白两种颜色选择,黑色售价169元,白色售价179元

2026-01-05B6,风冷散热器,影驰 -

国铁集团设定 2026 年目标:新线投产超 2000 公里,旅客发送量突破 44 亿

中国国家铁路集团有限公司于1月4日在北京召开了工作会议,会议提出了2026年铁路工作的主要目标。目标包括保持铁路安全稳定,完成旅客发送量44.02亿人,同比增长3.5%,货物发送量达到41.3亿吨,同比增长1.5%

2026-01-05国铁集团,中国铁路,高铁 -

宇树科技回应上市“绿色通道被叫停”:未申请,报道与事实不符

今日早些时候,有报道称宇树科技A股上市的绿色通道被叫停,但其上市进程并未受到影响。对此,宇树科技回应称,报道中涉及公司上市工作的内容与实际情况不符,公司从未申请过“绿色通道”。相关报道误导了公众认知,严重侵害了公司的合法权益

2026-01-05宇树科技,上市 -

乘联分会崔东树:2025 年全国汽车市场召回 129 批次 375 万台,累计召回数量同比下降 57%

乘联会崔东树对2025年车市汽车召回信息进行了盘点。数据显示,2023年累计召回181批次728万台,2024年累计召回160批次879万台,而2025年1-12月累计召回129批次375万台,累计召回数量同比下降了57%

2026-01-05汽车,乘联分会,汽车召回 -

联想旗下 moto 品牌首款大折叠手机 Razr Fold 曝光,有望明天官宣

消息源Evan Blass曝光了联想旗下moto品牌的首款大折叠手机Razr Fold的营销演示文稿,这是公众首次得知这款机型的存在

2026-01-05联想,摩托罗拉 -

华硕 ROG 魔盒 X 双频 AI 电竞路由器首销:单万兆 WAN 口、Wi-Fi 7,首发价 1999 元

华硕ROG魔盒X双频AI电竞路由器已在京东开启首销,主要面向高端电竞玩家。这款路由器配备一个万兆WAN以太网接口,正面的“败家之眼”Logo支持ARGB发光,售价2199元,首发价为1999元

2026-01-05ROG,魔盒,X -

基于联发科全球首款 5G-A 平台,移远通信推出车规级 5G R18 模组 AR588MA

移远通信宣布推出符合3GPP R18标准的车规级5G-A模组AR588MA

2026-01-05移远通信,AR588MA,联发科 -

荣耀产品线总裁方飞:一台既 Pro 又 Air 的手机即将和大家见面

今天上午,荣耀终端股份有限公司产品线总裁方飞在祝福大家2026年开工大吉的同时,也预热了荣耀Air新品

2026-01-05荣耀,Magic8,Air -

比亚迪海洋网成立四年累销超 620 万辆,2025 年度销售超 222 万辆

比亚迪汽车官方宣布,比亚迪海洋网成立四年累计销量超过620万辆;2025年度累计销量超过222万辆,同比增长14.05%;12月销售188838辆

2026-01-05比亚迪,海洋网 -

LG 家庭 AI 机器人 CLOiD 首秀,能叠衣服还能帮你上菜

LG 在 CES 2026 展览会期间首次展示了面向家庭场景的 AI 机器人 CLOiD。这款机器人能够完成叠衣服、清理洗碗机、送食物等多种家务任务

2026-01-05CES,2026,LG机器人 -

三星 Galaxy Tab A11+ 平板国行发售:天玑 7300、可选 5G 版,1699 元起

三星于2025年11月在海外部分地区推出了Galaxy Tab A11+平板,这款定位入门级的设备搭载了联发科天玑7300芯片

2026-01-04三星,Galaxy,Tab -

鹿客预热 1 月 6 日 CES 2026 展会全球首发“隔空充电 AI 智能锁 V7 Max”

鹿客宣布将在1月6日的CES 2026展会上全球首发“隔空充电AI智能门锁”V7 Max。发布的视觉海报显示,这款产品外观采用流线型设计,整体风格较为科幻

2026-01-04CES,2026,鹿客 -

荣耀 Power2 手机行业首发天玑 8500 Elite 芯片,1 月 5 日发布

荣耀Power2手机定于1月5日19:30发布。官方宣布,这款新机将首发天玑8500 Elite芯片,安兔兔跑分超过240万,在同档位中表现突出

2026-01-04荣耀,Power2,天玑 -

应对 DDR4 平台需求回升,技嘉紧急发布四款 AM4 主板新品

随着DDR5内存价格的上涨,许多玩家开始转向性价比更高的DDR4平台。技嘉抓住这一机会,在本周推出四款基于AM4接口的AMD主板新品,包括两款A520芯片组和两款B550芯片组,覆盖了Micro-ATX和Mini-ITX规格

2026-01-04AMD,主板,AMD -

2026 小鹏全球新品发布会官宣:新款 P7+、G7 定档 1 月 8 日中国上市,1 月 9 日欧洲上市

小鹏汽车宣布,其产品大幕将于2026年1月8日正式开启。新款小鹏P7+和G7将正式上市,1月8日在中国发布,次日在欧洲上市。 全球的小鹏车友被邀请共同见证“2026小鹏全球新品发布会”

2026-01-04小鹏汽车 -

石头科技与皇家马德里合作,CES 2026 将“首发具身智能黑科技”

石头科技昨晚宣布与皇家马德里成为全球合作伙伴,将在1月6日开幕的CES 2026展会上亮相。石头科技还透露,将在CES 2026上首发具身智能黑科技,引领家用清洁机器人进入全新时代

2026-01-04石头科技,CES,2026 -

公安网安部门依法对某人工智能服务科技有限公司予以行政处罚

9月15日,国家网络安全通报中心发布消息称,公安网安部门在“护网—2025”专项工作中发现,一家主营对外提供人工智能模型训练基础数据的科技公司,在处理人脸等生物识别类敏感个人信息前,未按《个人信息保护法》的相关规定进行个人信息保护影响评估

2026-01-04个人信息保护法,人工智能,人工智能服务科技有限公司 -

荣耀郭锐:安卓用两年就卡的标签应该被撕掉了,即将发布的 MagicOS10 会带来重大优化

荣耀终端股份有限公司品牌营销总裁、集团首席营销官郭锐近日发文探讨了“安卓卡顿是否还是刻板印象”的话题,认为安卓手机使用两年就卡顿的标签应该被撕掉

2026-01-04MagicOS10,荣耀 -

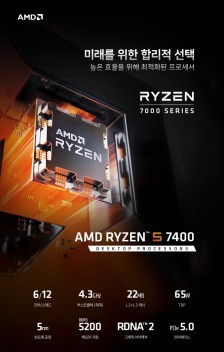

AMD 锐龙 5 7400 处理器现身韩国电商比价平台,4.3GHz 加速频率

9月16日,X平台用户포시포시 (@harukaze5719) 发现,AMD锐龙5 7400处理器现在可以在韩国电商比价平台danawa上找到

2026-01-04AMD,处理器,CPU -

消息称第二台高通骁龙 8 Elite Gen5、联发科天玑 9500 新机暂定 10 月 16 日前后发布

微博博主 @数码闲聊站 爆料称,第二台搭载高通第五代骁龙8至尊版以及第二台联发科天玑9500的新机预计将在10月16日前后发布

2026-01-04高通,骁龙,联发科 -

理想 i6 新形态五座 SUV 官宣 9 月 26 日上市:车长 4.95 米、低风阻造型设计

理想汽车宣布,其新形态五座SUV——理想i6将于9月26日正式上市。这款新车采用了独特的设计风格,包括一体式鲨鱼形态和上下双色车身。车身长度为4.95米,车内纵向可用空间超过3.3米。低风阻和低重心设计不仅降低了能耗,还提升了驾驶体验

2026-01-04理想汽车,理想,i6 -

《疯狂动物城 2》获 2026 元旦档票房冠军,即将超越《复仇者联盟 4》登顶进口片冠军榜

2026年元旦档(1月1日至1月3日)票房达到7.36亿,《疯狂动物城2》以2.19亿的档期票房成为冠军,并即将超越《复仇者联盟4:终局之战》,登顶中国影史进口片冠军榜

2026-01-04疯狂动物城,2,复仇者联盟 -

人形机器人登台唱戏:学习人类表演,精准复现戏曲身段

1月3日,2025《中国科技创新盛典》在CCTV-1频道播出。今年的节目在安徽合肥录制,特别策划了科技与戏剧结合的创演秀,创新演绎《徽班进京百戏入皖》

2026-01-04人形机器人