华为开源 SINQ AI 量化技术:显存占用最高削减 70%,单张 RTX 4090 能干 A100 的活

华为苏黎世计算系统实验室于9月26日发布了一项全新开源量化技术SINQ(Sinkhorn归一化量化),旨在大幅降低大语言模型的显存需求与运行成本。这项技术无需复杂的校准过程,可直接集成至现有工作流,并且其代码已通过Apache 2.0许可证在GitHub和Hugging Face上开放,允许任何组织免费使用、修改和商业化部署。

SINQ的核心优势在于其卓越的压缩性能。根据测试,该技术能将不同规模模型的显存占用普遍削减60%至70%。这意味着,过去需要超过60GB显存才能运行的大型模型,现在仅需约20GB的环境即可部署。此前需要企业级GPU(如英伟达A100 80GB或H100)计算的任务,现在仅用一张售价约1600美元的消费级显卡(如英伟达RTX 4090)便可胜任。对于云端用户而言,每小时的算力成本也随之锐减。

SINQ通过两大创新实现了性能突破。它采用“双轴采样”策略,替代了传统的单尺度因子量化,通过分别为矩阵的行和列设置独立的缩放向量,更灵活地分散量化误差,有效抑制了异常值的影响。此外,SINQ引入了一种受Sinkhorn迭代启发的快速归一化算法,用于平衡矩阵行列的标准差,从而最小化“矩阵不平衡”现象,提升了量化后的模型精度。

在性能评估中,SINQ的表现全面超越了多种主流的免校准量化方法(如RTN、HQQ)。在处理Qwen3、LLaMA等多种主流模型时,SINQ在WikiText2等标准测试集上显著降低了模型的困惑度,其性能表现接近甚至达到了需要数据校准的方案水平。SINQ的量化速度也极快,比HQQ快约2倍,更是比AWQ快30倍以上,充分满足了研究与生产环境中对效率的严苛要求。

量化是一种模型压缩技术,通过降低模型内部数据的精度来减小其体积和显存占用,类似于将一张高精度的照片转换为文件更小但肉眼看差别不大的普通照片,从而让模型运行得更快、更省资源。困惑度是评估语言模型性能的常用指标,衡量的是模型对于一段新文本的“惊讶”或“不确定”程度。困惑度越低,表示模型对文本的预测越准确,语言能力越强。

热点推送

-

亚马逊推出家用备份蜂窝网络接入设备 eero Signal,可选 4G / 5G 版本

亚马逊旗下家用网络设备制造商eero推出了一款新的备份接入设备eero Signal。这款设备在宽带接入出现故障时,可以通过蜂窝网络保障eero WiFi无线路由器始终在线,而在宽带恢复时会自动停用

2026-02-12亚马逊,eero -

通电即喷火:一博主意外拍到微星 RTX 5090 魔龙显卡自燃瞬间

B站Up主@晚睡等于早死昨晚上传了一段视频,展示了他新购买的RTX 5090魔龙显卡在开机时火花四溅并出现明火的悲惨遭遇。他赶紧关闭了电源,从某种角度来看,之前国外玩家RTX 4090电源连接线熔毁的问题相比之下显得不那么严重

2026-02-12微星,RTX,5090 -

CounterPoint:苹果 iPhone Fold 成关键催化剂,2026 引爆大折叠手机市场

市场调查机构CounterPoint Research预测,2026年将成为全球折叠屏智能手机市场的结构性拐点,市场重心正从形态新奇转向实用价值

2026-02-12CounterPoint,iPhone,Fold -

智谱对 GLM Coding Plan 套餐价格进行结构性调整,整体涨幅 30% 起

智谱今日发布GLM Coding Plan价格调整函,称近期市场需求持续强劲增长,用户规模与调用量快速提升。为保障高负载下的稳定性和服务质量,公司加大了算力与模型优化投入,产品能力不断升级

2026-02-12智谱,GLM,5 -

福布斯评选“美国 250 位最伟大创新者”,马斯克位居第一

《福布斯》杂志发布了“创新者 250”榜单,列出了美国最杰出的250位创新者。埃隆·马斯克位居榜首,英伟达CEO黄仁勋排名第五

2026-02-12马斯克,福布斯 -

联发科官方认领:奇瑞风云 T9L 汽车搭载天玑座舱 S1 Ultra,支持 54 TOPS NPU 算力

联发科官方微博宣布,奇瑞风云 T9L 汽车将搭载天玑座舱 S1 Ultra,采用 3nm 制程工艺,拥有 54 TOPS NPU 算力

2026-02-12天玑座舱,S1,Ultra -

鸿蒙 5 助力华为 nova 14 Ultra 亮相 ChinaJoy 2025,华为游戏生态又一突破性标志

8月1日,第二十二届中国国际数码互动娱乐展览会(ChinaJoy)在上海新国际博览中心举办。今年的ChinaJoy规模进一步升级,共有743家企业参展,展示了类型和风格多样化的技术和产品。 华为鸿蒙游戏展区吸引了众多玩家的目光

2026-02-12鸿蒙,5,ChinaJoy -

消息称联发科天玑 8500 芯片架构制程无重大变化,性能目标安兔兔跑分超 200 万

据消息源透露,联发科下一代中高端移动芯片天玑 8500 仍可能采用台积电 4nm 工艺制程。其全大核 CPU 架构变化不大,GPU 则在维持 Mali-G720 架构的同时提升规模,性能设定对应的安兔兔基准测试跑分超过 200 万

2026-02-12手机芯片,联发科,天玑8500 -

H810“坐拥”USB4,749 元铭瑄 MS-eSport H810M WIFI ICE 主板首销

铭瑄 Maxsun 旗下主板新品 MS-eSport H810M WIFI ICE 现已在京东开启首销,定价为 749 元

2026-02-12主板,铭瑄 -

梅赛德斯-AMG 新款 GT 四门电动车内饰首曝:运动型方向盘,动力预估超 1300 马力

汽车媒体carscoops发布了一组内饰照片,展示了第二代梅赛德斯-AMG GT四门电动车。这些照片展示了运动型方向盘和独立的曲面显示屏。 这款电动车的内饰设计延续了AMG GT XX概念车的设计理念

2026-02-12梅赛德斯AMG,GT,四门电动车 -

智谱最新旗舰模型 GLM-5 炸场:编程、智能体能力取得开源 SOTA 表现

今天晚间,智谱发布了新一代旗舰模型GLM-5。该模型在编程和智能体能力方面取得了开源领域的最佳表现,在实际编程场景中的使用体验接近Claude Opus 4.5,特别擅长处理复杂系统工程和长程智能体任务

2026-02-12人工智能,智谱,GLM5 -

奔驰全新入门车型最新爆料:融合 SUV 与 MPV,风格将与众不同

几年前,梅赛德斯-奔驰宣布将停产A级和B级两款“小车”,以精简紧凑型产品阵容,把资源集中在更高端车型上,从而在不扩大销量的情况下提升盈利能力。现在,奔驰计划推出一款全新形态的单一车型来填补A级与B级留下的市场空白

2026-02-12奔驰,奔驰A级,奔驰B级 -

苹果已于 2025 年收购加拿大图数据库公司 Kuzu,用途未明

苹果于去年10月收购了加拿大数据库公司Kuzu。欧盟对“重大”的定义并非取决于交易规模,而是看收购是否可能用于提供核心平台服务。 Kuzu成立于2023年,总部位于加拿大安大略省,被收购时员工规模约10人

2026-02-12Kuzu,图数据库,苹果 -

苹果 iOS/iPadOS 26.3 正式版发布

苹果今日向iPhone和iPad用户推送了iOS/iPadOS 26.3更新(内部版本号:23D127),距离上次正式版发布间隔了16天

2026-02-12iOS,iPadOS -

DDR5 内存暴涨后 AM4 平台再度走热:AMD R7 5800X/XT 成销量黑马,部分渠道已超过 7800X3D

近期,AMD Zen 3处理器再次热销,尤其是8核16线程的R7 5800X/XT系列

2026-02-12AMD,R7,5800XT -

xAI 联合创始人 Tony Wu 离职,创始团队近一半人都走了

xAI联合创始人Tony Wu宣布离职,他在X平台上表示:“是开启我人生新篇章的时候了。这是一个充满无限可能的时代:一支手握人工智能的小团队,足以移山填海,重新定义何为可能

2026-02-11xAI,Grok -

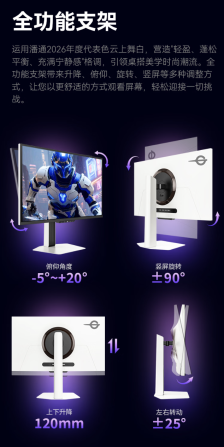

泰坦军团“X276S+”27 英寸显示器开售:2K 345Hz,1499 元

泰坦军团旗下型号为“X276S+”的27英寸显示器已在京东开售,主打2K 345Hz,定价1499元,部分地区国补后到手价低至1424元

2026-02-11泰坦军团,X276S+,显示器 -

新研究揭示:AI 非但未减负,反而加剧职场倦怠

在美国职场文化中,最吸引人的观点不再是人工智能会抢走工作,而是它能将人们从繁重的工作中解脱出来。过去三年里,科技行业一直在向数百万人推广这一理念,许多人也愿意相信这一点

2026-02-11人工智能,AI -

FCC 批准亚马逊再部署 4500 颗新卫星,星座总规模直奔 7700 颗

美国联邦通信委员会批准了亚马逊的申请,允许其再部署4500颗卫星,以扩大规划中的近地轨道卫星星座规模。这将使亚马逊的卫星总数达到约7700颗,增强与SpaceX的竞争能力

2026-02-11亚马逊,FCC,无线互联网 -

雷军总结昨晚小年直播,称新一代小米 SU7 定位就是新时代驾驶者之车

昨晚直播结束后,雷军对小年直播进行了总结。他带大家参观了小米汽车工厂的交付中心、展厅和定制中心。在科技展厅中展示了小米摩纳德架构、CTB 架构、大压铸件、YU7 铠甲笼式车身、EEA 等展区,还介绍了二楼的定制中心

2026-02-11小米,SU7,小米汽车 -

内存短缺冲击电脑市场,日本零售商求购用户二手设备

日本一家大型电脑及电子产品零售商正在恳请顾客出售闲置的旧电脑设备。东京秋叶原“电器城”的Sofmap Gaming官方X账号发文表示,如果顾客购置了新电脑,可以将旧的游戏PC卖给商店

2026-02-11电脑,内存 -

三星 Galaxy S26 Ultra 国行版现身工信部,支持 eSIM

一款型号为 SM-S9480 的三星新机最近现身工信部,据博主 @i冰宇宙 分析,这款手机可能是 Galaxy S26 Ultra 国行版

2026-02-11eSIM,Galaxy,S26 -

零跑 A10 欧洲市场命名为 B03X,已现身布鲁塞尔车展

零跑A10在欧洲市场命名为B03X,已在布鲁塞尔车展完成首秀。此前有传闻称命名调整与商标有关。 这款新车已出现在工信部1月8日发布的第403批《道路机动车辆生产企业及产品公告》中

2026-02-11零跑,A10,零跑 -

上海同济大学成立机械工程与机器人学院、汽车与能源学院

1月10日,同济大学在嘉定校区举行了机械工程与机器人学院、汽车与能源学院的成立暨学科发展研讨会。原机械与能源工程学院更名为“机械工程与机器人学院”,原汽车学院更名为“汽车与能源学院”

2026-02-11同济大学 -

谷歌将 Gemini AI 助理引入 Gmail,可提供对话摘要、问答等功能

谷歌本周宣布旗下Gmail电子邮箱正式上线多项AI功能,标志着Gmail进入了Gemini时代。用户现在可以用自然语言向Gmail提问并得到答案

2026-02-11Gmail,谷歌,Gemini -

苹果 iPhone 17 Pro Max 续航测试:WiFi 比 5G 多约 3 小时使用时长

最近,博主PhoneBuff进行了一项续航基准测试,旨在比较WiFi上网和5G蜂窝网络在能耗上的差异

2026-02-11iPhone,17,Pro -

消息称 OpenAI 首款硬件产品放弃“io”品牌名,明年 2 月底前不会交付给消费者

据《连线》杂志报道,一份法院文件显示OpenAI将不会在其首款AI硬件产品上使用“io”品牌名。此前,音频设备初创公司iyO曾对OpenAI提起商标侵权诉讼,当时OpenAI刚刚收购了前苹果首席设计官乔纳森·伊夫创立的io公司

2026-02-11OpenAI,io,AI -

三星 Galaxy S26 系列完整规格曝光:欧版采用 Exynos 2600 与骁龙双平台,预计 2 月 25 日正式发布

尽管三星尚未正式公布Galaxy Unpacked发布会的具体时间,但关于Galaxy S26系列的详细信息已经提前曝光

2026-02-11三星,Galaxy,S26 -

雷军介绍小米汽车 2026 年春节无忧服务:车坏路上免费救援,另可报销 1500 元高铁机票

小米创办人、董事长兼CEO雷军在小年夜直播中透露,小米汽车为2026年春节假期出行提供了暖心服务。从即日起至3月3日(元宵节),所有小米汽车车主可以享受24小时免费道路救援服务

2026-02-11小米汽车,雷军 -

华硕创意国度 ProArt MD301 办公鼠标发售:即插式微动仓、180 天续航,599 元

华硕创意国度ProArt MD301办公鼠标现已发售,定位中高端市场,支持三模无线连接,最高DPI可达8000,售价599元。 这款鼠标采用人体工学曲线设计,贴合手掌自然弧度,使操作更加自如

2026-02-11华硕